Data Lifecycle statt Datensilos

Quelle: ZIA/EY, „Digitalisierungsstudie 2025 – Data Lifecycle Management in der Immobilienwirtschaft“

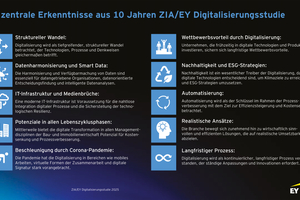

Quelle: ZIA/EY, „Digitalisierungsstudie 2025 – Data Lifecycle Management in der Immobilienwirtschaft“

Quelle: ZIA/EY, „Digitalisierungsstudie 2025 – Data Lifecycle Management in der Immobilienwirtschaft“

Quelle: ZIA/EY, „Digitalisierungsstudie 2025 – Data Lifecycle Management in der Immobilienwirtschaft“

Die Jubiläumsausgabe der Digitalisierungsstudie des ZIA und EY Parthenon zeigt, dass die Immobilienbranche vorangekommen ist: Sie hat den Sprung von Pilotversuchen zu skalierbaren Anwendungen geschafft – doch der Durchbruch im Betrieb gelingt nur dort, wo Daten entlang des gesamten Lebenszyklus einer Immobilie sinnvoll verbunden werden.

Cloud, Plattformen und KI sind verfügbar, aber ihr Nutzen hängt an der Qualität der Übergaben, an verständlichen Datenmodellen und nicht zuletzt an den Teams, die Verantwortung für Datenprozesse übernehmen. Data Lifecycle Management (DLM) wird damit zur organisatorischen Klammer, die technische Möglichkeiten in messbare Resultate für Kosten, Verfügbarkeit und ESG übersetzt.

Vom Piloten bis zum Betrieb

Die Jubiläumsausgabe der Studie zeichnet ein differenziertes Bild: Nach einer Phase sichtbarer Leuchttürme hat sich der Alltag professionalisiert. Heute sind Cloud‑Lösungen in vielen Unternehmen die bevorzugte Betriebsform; dadurch steigen Standardisierung und Skalierbarkeit, aber auch der Integrationsaufwand. In der Praxis koexistieren zentrale ERP‑ und CAFM‑Plattformen mit spezialisierten SaaS‑Werkzeugen. An der Schnittstelle entscheidet sich, ob Daten mühelos fließen oder ob Medienbrüche zu Doppelarbeit und Reibungsverlusten führen. Für FM‑Teams bedeutet das: Schnittstellen‑ und Prozesskompetenz werden zur täglichen Kernaufgabe – nicht als IT‑Exkurs, sondern als Voraussetzung für stabile Services.

Data Lifecycle Management (DLM)

DLM beschreibt den bewussten Umgang mit Daten von der Planung über den Bau und den Betrieb bis zur Verwertung. Ziel ist es, Informationen so zu strukturieren, dass sie Entscheidungen stützen und sich über Unternehmensgrenzen hinweg nutzen lassen. Eine deutliche Mehrheit der Befragten halten DLM für relevant und planen die strategische Verankerung; gleichzeitig bremsen Kosten, technologische Grenzen und fehlende Kompetenzen die Umsetzung. Daraus folgt: DLM ist weniger ein Tool‑Projekt als ein Organisationsprogramm. Wer Wirkung erzielen will, priorisiert konkrete Anwendungsfälle – etwa Energieoptimierung, Verfügbarkeits‑ und Wartungssteuerung oder Flächennutzung – und leitet daraus Datenbedarf, Übergabepunkte und Pflegeprozesse ab. So entstehen klare Verantwortlichkeiten, nachvollziehbare Qualitätsniveaus und ein gemeinsames Verständnis darüber, welche Daten wirklich gebraucht werden.

Cloud setzt sich durch

„Cloud first“ hat sich etabliert, weil damit Updates, Skalierung und neue Funktionen schneller möglich sind. Gleichzeitig zeigt die Studie, dass hinter erfolgreichen Cloud‑Einführungen stets saubere Integrationsarbeit steckt. Anstelle der Hoffnung auf die eine, alleskönnende Suite setzt sich ein vernetzter Ansatz durch: zentrale Plattformen, ergänzt um spezialisierte Dienste, die über definierte Schnittstellen zusammenspielen. Wer Ausschreibungen und Projekte nach dem Prinzip „API first“ gestaltet, vermeidet spätere Engstellen. Ebenso wichtig sind verbindliche Datenpakete zwischen Bau und Betrieb sowie eine systematische Eingangsprüfung, die Vollständigkeit und Plausibilität sicherstellt. Erst wenn diese Grundlagen stehen, entfaltet sich der operative Nutzen im Tagesgeschäft.

Datenqualität mit Augenmaß

Für regulatorisches Reporting braucht es prüfsichere Daten; für Anomalie‑Erkennung oder Ticket‑Clustering reicht oftmals ein „gut genug“, wenn Validierungs‑ und Korrekturschleifen greifen. Entscheidend ist, Qualitätsziele je Anwendungsfall zu definieren und Pflegeaufwände am erwarteten Nutzen auszurichten. So wird aus Datenpflege kein Selbstzweck, sondern ein Effizienzhebel. Unternehmen, die diesen Weg gehen, berichten von schnelleren Durchlaufzeiten, geringerer manueller Nacharbeit und einer höheren Akzeptanz in den operativen Teams.

KI – reif für den Betrieb?

Der Studie zufolge gelten KI‑basierte Auswertungen und Ökosystemansätze als kurzfristig einsatzfähig. Produktiv werden sie jedoch erst, wenn Daten semantisch anschlussfähig sind – also wenn Anlagen, Sensoren, Störungen und Leistungen durch ein gemeinsames Datenmodell beschrieben werden. Dort, wo diese Basis geschaffen wurde, lassen sich Störmeldungen automatisch vorsortieren, Wartungsfenster vorausschauend planen und Energieverbräuche kontinuierlich optimieren. Besonders FM‑nahe Organisationen profitieren, wenn Ontologien und Schnittstellen gemeinsam mit dem Betrieb entwickelt werden und wenn der Erfolg über klare Metriken wie SLA‑Quote, MTTR oder kWh/m² sichtbar gemacht wird.

Der eigentliche Engpass: Menschen und Organisation

Technologie ist selten das größte Problem. Häufig fehlen eindeutige Rollen und ausreichend Zeit für die Pflege von Stammdaten, Sensorik und Prozessschnittstellen. Ein erprobter Ansatz ist die Rolle eines „Data Product Owner“, verankert in Asset‑, Property‑ oder FM‑Teams und eng verzahnt mit IT und Betrieb. Diese Funktion verantwortet Datenmodelle und Datenverträge, priorisiert Backlogs gemeinsam mit den Fachbereichen und sorgt dafür, dass neue Projekte und Verträge von Beginn an klare Übergaben und Exit‑Regelungen enthalten. Wo diese Verantwortung sichtbar ist, steigt die Datenqualität, und Integrationsprojekte werden beherrschbarer.

Von der Checkliste zum Vorgehensmodell

Anstelle langer Anforderungskataloge empfiehlt die Studie ein schlankes Vorgehen: Ausschreibungen und Verträge werden von vornherein auf Datenportabilität und Interoperabilität ausgerichtet. Ein gemeinsames, versioniertes Schema definiert, welche Informationen in welcher Granularität übergeben werden. API‑Dokumentationen und Ereignisschnittstellen bilden den technischen Rahmen, während vertragliche Daten‑SLAs die Aktualität und Reaktionszeiten absichern. In hybriden IT‑Landschaften ist dieser Rahmen keine Kür, sondern die Voraussetzung dafür, dass Investitionen in Automatisierung und KI im Betrieb tatsächlich ankommen.

Steuerung über aussagekräftige KPIs

Wirkung entsteht, wenn Fortschritt messbar wird. Unternehmen, die das Thema DLM konsequent angehen, bündeln ihre Steuerung auf wenige Kennzahlen: Etwa die Einhaltung von Service Levels und Reparaturzeiten, die Automatisierungsquote im Ticketfluss, die Vollständigkeit und Aktualität kritischer Stammdaten sowie Energie‑ und Emissionswerte je Fläche. Diese Kennzahlen werden quartalsweise überprüft und mit konkreten Verbesserungsmaßnahmen verknüpft – etwa der Erweiterung automatisierter Messpunkte, der Reduktion manueller Datenerfassung oder der Anbindung weiterer Schnittstellen. So bleibt die Transformation greifbar und verliert nicht an Tempo.

Realistische Roadmap

Am Anfang steht ein ehrlicher Reifegrad‑Check: Welche Use Cases bringen kurzfristig Wirkung, und welche Daten fehlen dafür?

Auf dieser Basis entsteht ein Zielbild, das Datenmodelle, Schnittstellen und Verantwortlichkeiten festlegt. Die Umsetzung beginnt bewusst klein – etwa mit automatisierter Zählerauslesung und einem intelligenten Routing von Störmeldungen – und wird dann auf weitere Liegenschaften und Prozesse skaliert. Parallel dazu werden Ontologien geschärft, Monitoring und Datenqualitätsprüfungen etabliert und vertragliche Regelungen für Datenportabilität ergänzt. Nach rund einem Jahr lässt sich die Wirkung im Portfolio messen und gezielt nachschärfen.

Risiken und Compliance im Blick

Mit wachsender Vernetzung steigen Anforderungen an Datenschutz, Informationssicherheit und Resilienz. Wer frühzeitig Rollen‑ und Rechtekonzepte, Protokollierung und Verschlüsselung implementiert, reduziert operative Risiken und schafft Vertrauen bei Eigentümern, Mietern und Dienstleistern. Ebenso wichtig sind klare Offboarding‑Prozesse und vertraglich gesicherte Datenrückgabe, um Abhängigkeiten beherrschbar zu halten. In Kombination mit den ESG‑ und Taxonomie-Anforderungen ergibt sich so ein belastbarer Rahmen, in dem digitale Services nachhaltig betrieben werden können.

Fazit

Die Branche hat die technischen Weichen gestellt – doch Mehrwert entsteht erst durch konsequentes Datenmanagement über den gesamten Lebenszyklus. Wer DLM organisatorisch verankert, Integration als Daueraufgabe versteht, Datenqualität an den Nutzen koppelt und KI auf ein belastbares Datenmodell setzt, erzielt spürbare Effekte: niedrigere Betriebskosten, höhere Verfügbarkeit und mehr Transparenz in Richtung ESG. So wird aus „Cloud first“ im täglichen Betrieb tatsächlich „Value first“.